El pasado 13 de marzo falleció el filósofo estadounidense Hilary Putnam. Con su muerte, la filosofía académica pierde a uno de los pocos «filósofos totales» todavía vivos. Es esta una denominación que define a aquellos pensadores que han cubierto de forma competente y muy personal, y desde una sólida formación humanística y científica, una gran variedad de disciplinas filosóficas. En este sentido, Putnam comparte podio con eximias y venerables figuras como Nicholas Rescher o Mario Bunge. Por fortuna, éstos aún habitan entre nosotros.

En efecto, Putnam ha abarcado en su quehacer de pensador cuestiones relacionadas con la fillosofía matemática, la filosofía de la computación, la filosofía de la ciencia, la filosofía del lenguaje y de la mente, la epistemología, la filosofía moral y la filosofía política. También ha realizado contribuciones importantes en estudios metamatemáticos de gran perfil técnico, como la resolución, en un sentido negativo, del décimo problema de Hilbert, relacionado con la existencia de algoritmos para la búsqueda de valores enteros que satisfagan las ecuaciones diofánticas (ecuaciones cuyos coeficientes son también números enteros). Esta formación matemática ha orientado, según creo, la forma en la que Putnam ha abordado algunos de sus estudios filosóficos más importantes y la manera en la que ha respondido a estas cuestiones.

Suele señalarse que la trayectoria intelectual de Putnam ha estado marcada por una serie de volantazos que han causado algunos llamativos cambios de carril en su producción filosófica. Y es cierto, como veremos, que nuestro pensador ha atravesado distintos paradigmas filosóficos a lo largo de su dilatada carrera. Pero también es verdad que hay una continuidad que subyace al conjunto de su obra. Comentaremos ambos aspectos más adelante. Lo que parece importante resaltar en estos preliminares es el profundo compromiso de Putnam con la filosofía, como actividad diferenciada del resto de saberes humanos. A diferencia de sus mentores intelectuales, los positivistas lógicos (Hans Reichenbach fue el director de su tesis doctoral), Putnam siempre trato de sustanciar el pensamiento filosófico más allá de una pura caracterización lingüística y lógica del pensar. A diferencia de otros filósofos coetáneos como Michael Dummett o Richard Rorty, Putnam se resistió a la banalización conceptual de la noción de «verdad» (frente a Dummett) y fintó como pudo los embates del relativismo epistemológico (frente a Rorty). A diferencia de lo que Putnam consideraba como «dogma cientificista» del conocimiento, nuestro pensador no dudo en pasarse con armas y bagajes filosóficos a la trinchera de las humanidades (sobre todo en su última etapa intelectual Putnam sostuvo que la filosofía era un saber humanístico, no científico). Además, Putnam abordó prácticamente sin solución de continuidad algunas obsesiones filosóficas típicamente académicas: léase la referencia, la intencionalidad, la verdad, el significado o la relación mente-cuerpo. En este sentido, y como se verá más adelante, nuestro filósofo nunca dejó de responder al estereotipo de pensador académico, en curioso contraste con su marcado activismo político en los años sesenta y setenta.

Después de este breve desglose, pretendo abordar con inevitable trazo grueso el itinerario filosófico de Putnam desde cuatro puntos de vista. Y ya que el propio Putnam consideraría la actividad filosófica como una Peregrinatio academica, vamos a sugerir algunos periplos temáticos que, espero, ayudarán a entender un poco la obra de este ilustre pensador.

En primer lugar, el inevitable periplo cronológico, o biografía intelectual, que situará la evolución de la obra putnamiana a lo largo de tres estadios más o menos bien definidos. No se trata de un mero ejercicio escolar, sino de una descripción útil que permitirá encuadrar el pensamiento de nuestro autor.

En segundo lugar, el periplo icónico. Putnam, como otros muchos filósofos, acostumbraba a recurrir a experimentos mentales y a figuraciones de lo cotidiano para ilustrar sus puntos de vista. En su caso, han alcanzado expecial fortuna los experimentos mentales de los Cerebros en Cubetas y la Tierra Gemela. También ha utilizado imágenes familiares, como gatos sobre esteras, a modo de ejemplos de sus postulados sobre el llamado «problema de la referencia».

En tercer lugar, el periplo proponedor, que pretende recoger algunas de las tesis más celebradas de nuestro filósofo, como el funcionalismo mental, la teoría causal de la referencia, la relatividad conceptual, la equivalencia descriptiva o la inseparabilidad entre hecho y valor.

En cuarto y último lugar, el periplo patético (de pathos). En él, pretendo listar algunas de las guías emocionales de Putnam destinadas, en cierto modo, a convencer a sus lectores de la necesidad de asumir ciertos compromisos filosóficos. Entre éstos, la destrucción de la dicotomía entre el realismo metafísico y el relativismo, el diálogo conflictivo con el relativismo, la reivindicación de una agenda propia para la filosofía, la relevancia del sentido común y del marco democrático de discusión y la idea que, en cierto modo, corona a todas las anteriores: el florecimiento humano o eudaimonía.

Podríamos, sin duda, insertar un quinto periplo, el periplo vital. Pues Hilary Putnam no se limitó a ser un estereotipo de brillante y parsimonioso pensador académico. Antes bien, sus compromisos políticos, su inicial ateísmo y su posterior conversión al judaísmo (él era judío por parte de madre) hacen de él un personaje con un indudable interés biográfico. Putnam desarrolló una intensa actividad política en los años sesenta y setenta en favor de los derechos civiles en Estados Unidos y en contra de la guerra de Vietnam. Militó durante un tiempo en el Partido Progresista del Trabajo (Progressive Labor Party), una formación marxista escindida del Partido Comunista de Estados Unidos en 1962, que posteriormente abandonó. No obstante, nunca se desligó del todo de su compromiso social y preservó siempre un enfoque progresista. No me adentraré, sin embargo, en esta interesante faceta de nuestro autor y preferiré centrarme en los aspectos puramente filosóficos de su biografía.

En esta primera entrada detallaremos el periplo cronológico. En una entrada posterior enfrentaremos el resto de periplos y trataremos de extraer algunas conclusiones sobre el carácter del pensamiento filosófico de Putnam. Por cierto, el libro del profesor Moris Polanco, Realismo y pragmatismo. Biografía intelectual de Hilary Putnam es un excelente estudio preliminar para los interesados en la filosofía putnamiana. De él se han tomado un número no pequeño de contenidos en el desarrollo de esta entrada, incluida la periodificación en diferentes etapas de la filosofía de Putnam y la caracterización de los aspectos más notables en cada una de ellas.

Vayamos, pues.

Hilary Putnam (1926-2016). Imagen tomada de Wikipedia.

El periplo cronológico

Es habitual dividir el trayecto filosófico de Hilary Putnam en tres períodos más o menos bien establecidos. Un primer período, llamado de realismo metafísico, abarca el intervalo comprendido entre los años 1957 y 1976. En estos años, Putnam se centra fundamentalmente en cuestiones de filosofía de la lógica, filosofía de la ciencia y de las matemáticas y filosofía del lenguaje. En muchos casos, las diferencias con respecto al segundo período, el de realismo interno (que encaja temporalmente entre los años 1977 y 1985) son más de matiz o de énfasis en distintos problemas que de contenidos sustanciales. Pues en este segundo período la atención del filósofo se dirige hacia cuestiones semánticas, especialmente la referencia, la intencionalidad, la relatividad conceptual y la definición de «verdad».

En realidad, Putnam nunca fue un realista metafísico sensu stricto. Nunca afirmó la existencia completa y acabada de una realidad física exterior con un amueblamiento completo y perfectamente definido de cosas, propiedades y estados ya conceptualizados (ésta es una expresión del propio Putnam), ni tampoco sostuvo la posibilidad de una única teoría verdadera que describiera isomórficamente el mundo con base en una noción de verdad como correspondencia perfecta entre las palabras y las cosas, o entre las teorías y los estados de cosas. En su etapa de realismo «metafísico», sus intereses reflexivos van encaminados hacia cuestiones más concretas. Por ejemplo, la tesis del carácter semiempírico de la lógica, la matemática y de la geometría (Putnam afirmará que las nociones matemáticas se refieren a objetos reales, aunque no se trate de objetos propios ideales o platónicos). O la naturaleza esencialmente trivalente de la lógica de los fenómenos microcósmicos, un ámbito en el que las proposiciones pueden ser verdaderas, falsas, o poseer un valor de verdad indeterminado. Al igual que la función de onda, Putnam sostiene en este momento que la lógica cuántica trivalente «colapsa» en una lógica clásica bivalente aplicable al meso- y al macrocosmos.

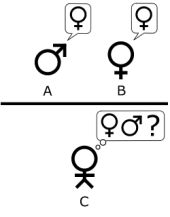

Lo que en realidad define este período como metafísico es la hipótesis del funcionalismo y la defensa de algunos postulados habituales en este escenario, como la existencia independiente de la mente de los objetos de los que la ciencia se ocupa (ya sean electrones o gatos en esteras) o la consideración de las teorías científicas como aproximaciones sucesivas a la verdad, y no como conjeturas provisionales more Popper. Putnam propone la tesis funcionalista como una interpretación de la naturaleza de los estados mentales que no sea deudora del materialismo fisicista de la teoría de la identidad. Esta teoría defiende la correspondencia biunívoca (uno a uno) entre estados mentales y estados cerebrales: cada estado mental es un estado cerebral físicoquímicamente determinado. Putnam, por el contrario, equipara los estados mentales a estados funcionales (inspirados en la teoría de la computación de Turing) y dice que los estados cerebrales son sólo instancias concretas de los estados funcionales; éstos podrían quedar también instanciados en soportes no biológicos, como circuitos impresos y redes de microchips, por ejemplo.

En el ámbito de este primer realismo también defiende Putnam la tesis no epistémica de la verdad, lo que viene a querer decir que la verdad de una afirmación referida a un objeto o a un estado de cosas va más allá de las posibilidades de verificación empírica de esa afirmación. La razón estribaría en que los hablantes nunca pueden conocer completamente la naturaleza de las cosas a las que se refieren. No obstante lo cual, se pretende hacer valer la existencia de una cierta relación de correspondencia entre las palabras y las cosas; se trata de un guiño a la tradicional teoría realista de la verdad (la verdad como correspondencia). Ahora bien, en estos años de supuesto realismo metafísico Putnam idea ya dos de sus propuestas más célebres, y que mantendrá a lo largo de su larga carrera: se trata de la tesis de la relatividad conceptual y de la teoría causal de la referencia.

La primera dice que pueden existir múltiples descripciones epistémicamente equivalentes de la realidad física y que no existe un contexto de interpretación privilegiado, por la sencilla razón de que la compartimentación del mundo externo en objetos o grupos de objetos, así como la identificación de propiedades y relaciones entre aquéllos y la caracterización de estados, eventos y procesos es algo que corre de nuestra cuenta en tanto criaturas pensantes. Por supuesto, no se trata de modelos interpretativos caprichosos, porque su mayor o menor bondad epistemológica va a venir dada por su mejor o peor funcionamiento y su grado de eficacia. Esto es lo que Putnam denomina una «negociación» entre la teoría en cuestión y la propia realidad. De este modo, el filósofo busca escapar del relativismo constructivista por el que siente un profundo rechazo. O al menos eso dice él, y tenemos la obligación de creerle.

La teoría causal de la referencia, por su parte, sostiene que el significado de las palabras y de las proposiciones no es un fenómeno puramente mental; es decir, no se trata de un determinado estado psicológico del hablante que establece de forma inequívoca la extensión del término en el que está pensando (la extensión de un término es el conjunto de cosas u objetos abarcados por dicho término). Más bien al contrario, es la propia realidad externa, aunque conceptualizada por nosotros, la que determina a qué cosas u objetos se refiere el término en cuestión. De este modo, la causa de la referencia no es mental, o no es sólo mental, sino también externa a la mente del hablante. Putnam completará esta teoría causal con una teoría social de la referencia, en el que los objetos o cosas referidos por un término vienen determinados por el uso del lenguaje que lleva a cabo una comunidad lingüística en «negociación» con la realidad conceptualizada. Para ilustrar esta tesis, nuestro autor nos llevará de viaje hacia una Tierra Gemela idéntica en todo a nuestra Tierra salvo por el hecho de que allí, el agua es un líquido de composición química diferente a nuestro «agua». Más adelante veremos de qué trata todo esto.

El período de realismo interno -consagrado y desarrollado en su libro Reason, Truth and History («Razón, verdad e historia») de 1981 mantiene esencialmente inalteradas -de hecho, quedan reforzadas- las dos tesis que he mencionado arriba, pero conlleva algunos cambios significativos en otros aspectos. Por ejemplo, renuncia a la teoría funcionalista de la mente por entender que se trata de una versión suavizada de la teoría de la identidad. También modifica su tesis sobre la verdad: de una noción no epistémica y no verificacionista (una proposición puede ser verdadera pero imposible de verificar) transita hacia una concepción aledaña al verificacionismo: la verdad será ahora equivalente a una justificación -aceptabilidad- racional idealizada. Y estas condiciones ideales de aceptabilidad racional remiten a una especie de función trascendente de la razón, algo que va a poner en contacto el recién estrenado realismo internalista de Putnam con la teoría kantiana del conocimiento. Pero en lo que más parece identificarse el filósofo americano con el ilustre pensador alemán es en la aceptación del papel de la mente como reguladora conceptual del mundo, como, diríamos, «amuebladora» de la realidad física exterior. Aunque, todo hay que apuntarlo, Putnam rechaza la idea de una realidad nouménica incognoscible, y ésta no es una diferencia pequeña. El lema de esta nueva fase en el pensamiento putnamiano podría ser una frase ya consagrada en su obra: «La mente y el mundo construyen conjuntamente la mente y el mundo». O bien, expresado de manera algo diferente: «los objetos son tanto construidos por nosotros como descubiertos por la experiencia».

En el realismo interno cobra una fuerza especial la teoría causal de la referencia como debeladora de algo que a Putnam le parece inquietante: la interpretación «mágica» de la referencia. Putnam problematiza de una forma pormenorizada el problema de la referencia y el aledaño problema de la intencionalidad. ¿Qué es lo que hace que nos refiramos a los objetos del mundo? ¿Es la referencia algún tipo de relación sustancial que empareja las palabras (los pensamientos, las imágenes mentales) con las cosas? ¿Cuál es la mediación, si la hay, entre la mente y el mundo a la hora de producir interpretaciones -teorías- verosímiles y que demuestran su eficacia en la manipulación del mundo físico y en la predicción acertada de eventos y procesos exteriores a la mente? Putnam tratará de responder a estos interrogantes echando mano de su tesis reforzada de la relatividad conceptual y de la equivalencia de las descripciones: si el amueblamiento del mundo, su partición en cosas y conjuntos de cosas, o en clases naturales de cosas es fruto de la mente humana al aplicar las habilidades de uso lingüístico que se dan en su comunidad, habilidades que surge de la «negociación» con el mundo, entonces el problema de la referencia se diluye, se convierte en un pseudoproblema. Y esto es así porque el presunto misterio de la correspondencia entre las palabras y las cosas se transparenta en una corespondencia entre nuestros signos lingüísticos y nuestros propios conceptos, conceptos que reflejan una partición verosímil del mundo en cosas, conjuntos de cosas, estados de cosas y relaciones entre éstas. Y lo que separa a esta perspectiva del relativismo metafísico es, justamente, el enganche con la realidad, una realidad preexistente pero inconceptualizada. La referencia, esa extraña cualidad de correspondencia entre las palabras y las cosas, es siempre interna a un marco conceptual, a una partición teórica del mundo en objetos de uno u otro tipo, a un amueblamiento sobreimpuesto al entorno de los mentantes.

El tercer período, conocido como el del realismo directo, humano o natural, arranca en el año 1986, año anterior a la publicación del libro The Many Faces of Realism (1987) y se prolonga hasta los últimos días de nuestro filósofo. Dos insistencias marcan esta época: el rechazo de la teoría de los datos sensoriales (sense-data) y de las representaciones mentales como intermediarios entre la mente y el mundo y la pulsión pragmatista, que solidifica en una sentida reflexión sobre la naturaleza de la labor filosófica, la democracia como marco inevitable de discusión e intercambio libre de opiniones y, sobre todo, la idea de florecimiento humano o eudaimonía, verdadera piedra angular del edificio intelectual putnamiano, especialmente en este período.

Por una parte, el rechazo de la tesis de las representaciones mentales como intermediarios entre la mente y el mundo es resultado de la insatisfacción de Putnam con el propio concepto de intermediario mental. Pues, tal y como lo ve ahora, las representaciones mentales son, en definitiva, parte de la mente y por tanto no constituyen una interfaz válida que permita una comunicación real de doble cara entre el ser mentante y el mundo exterior. Animado por la lectura de los pragmatistas americanos, en especial William James y John Dewey, y por el filófoso británico John Austin, Putnam parece decidirse por un «giro hacia la inocencia» y aceptar la colisión directa entre la mente y el mundo: conocemos, no las cosas del mundo a través de nuestras representaciones mentales, sino las cosas del mundo directamente, sin intermediación alguna. En esta nueva transición intelectual, nuestro autor encontrará un nuevo apoyo filosófico en el segundo Wittgenstein, el de las Investigaciones Filosóficas y los juegos de lenguaje.

El realismo directo es un realismo de sentido común y un rechazo de las consecuencias epistemológicas de la escisión cartesiana entre un conjunto de estados mentales internos y un mundo exterior perfectamente amueblado y sólo describible por una única teoría definitivamente verdadera. Se trata de reivindicar el «sentido común» y el entramado de conceptos e ideas que emanan de él; se trata de repensar filosóficamente ese sentido común. Ahora bien, no se trata de recomponer alguna forma de realismo metafísico; antes bien, las tesis de la relatividad conceptual y la equivalencia de las descripciones siguen teniendo rabiosa vigencia en Putnam, al igual que el papel cuasitaumatúrgico del lenguaje y la habilidades y usos lingüísticos en la configuración de los hechos y el carácter de la verdad como un tipo de aceptación racional justificada. Prestemos entonces atención al enganche con el sistema de valores: aquél se da a través de la racionalidad, que opera como presuposición básica todo lo anterior (por ejemplo, de la producción conceptual de hechos), y presupone a su vez las ideas de coherencia, completitud inferencial, análisis de consecuencias, elección de medios y fines y otras similares. Tales ideas son otras tantas expresiones de valores humanos. Y así, mediante conexiones indirectas pero secuenciales llega a establecerse la pertenencia de los hechos y los valores a una misma realidad original.

La realidad de lo que supone ser un ser humano.